1. 个性化定制专属deepseek应用

DeepSeek 太爆火总是服务太拥挤?手把手教你零成本私有化部署云服务,每月 10000 分钟免费额度!

声明:该公众号大部分文章来自作者日常学习笔记,也有部分文章是经过作者授权和其他公众号白名单转载.

未经授权,严禁转载,如需转,联系开白.

请勿利用文章内的相关技术从事非法测试,如因此产生的一切不良后果与文章作者和本公众号无关.

现在只对常读和星标的公众号才展示大图推送,建议大家把「雪之梦技术驿站」“设为星标”,否则下次可能看不到了!

1.1. 什么是Ollama

Ollama 是一个专为简化大型语言模型部署和服务而设计的工具.

官网链接: https://ollama.com/

- 安装配置参考如下:

curl -fsSL https://ollama.com/install.sh | sh

安装成功后命令行运行ollama -v验证安装是否成功!

- 创建用户和组

sudo useradd -r -s /bin/false -U -m -d /usr/share/ollama ollama

sudo usermod -a -G ollama $(whoami)

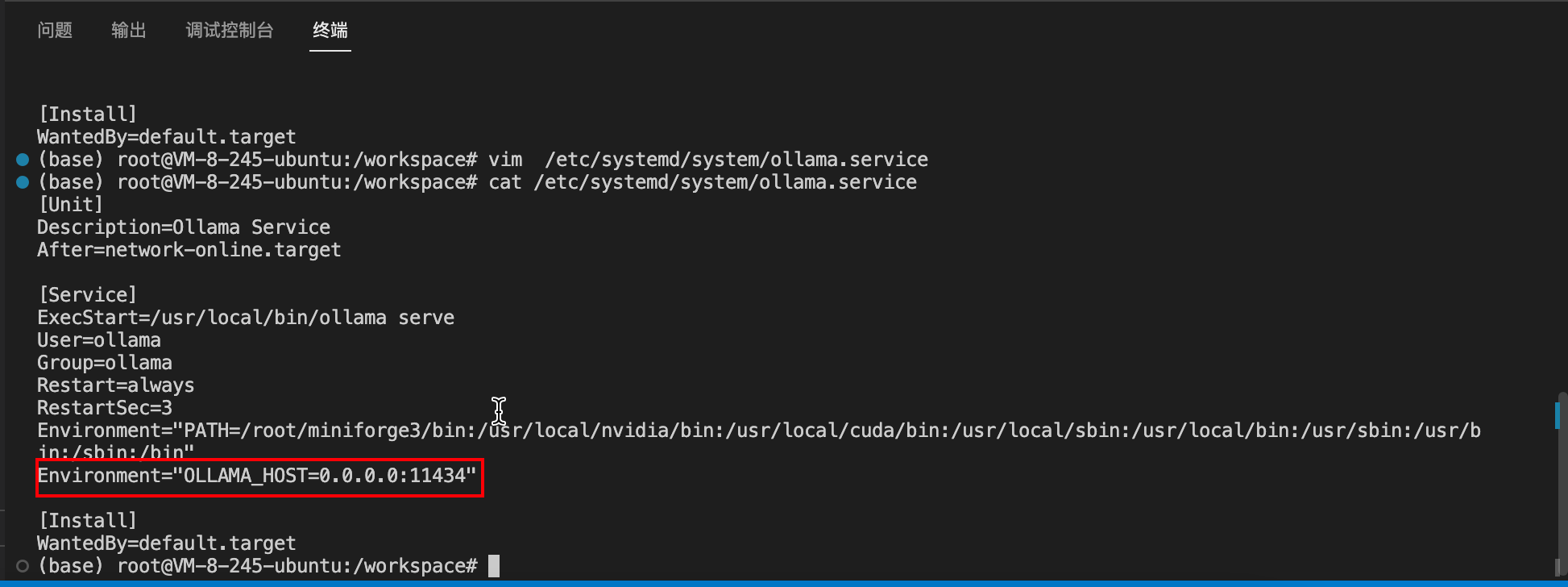

- 编辑配置文件:

llama 服务默认只允许 127.0.0.1:11434 访问,在配置文件中追加下面配置:

vim /etc/systemd/system/ollama.service

Environment="OLLAMA_HOST=0.0.0.0:11434"

echo 'export OLLAMA_HOST="http://0.0.0.0:11434"' >> ~/.bashrc

source ~/.bashrc

# export OLLAMA_HOST=http://0.0.0.0:6399

- 重启 Ollama 服务

启动Ollama服务: /usr/local/bin/ollama serve

sudo systemctl daemon-reload

sudo systemctl stop ollama

sudo systemctl start ollama

sudo systemctl enable ollama

sudo systemctl restart ollama

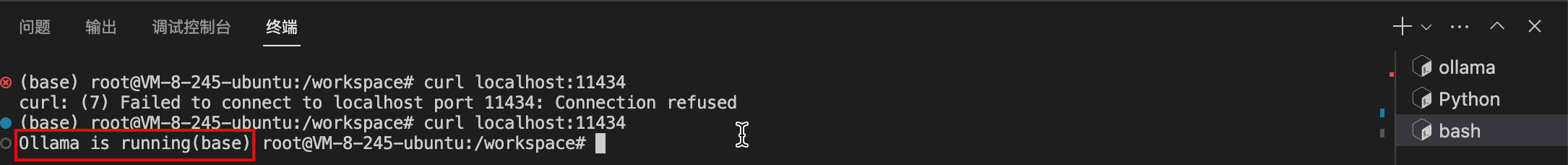

验证服务是否启动成功:

curl localhost:11434

Ollama is running

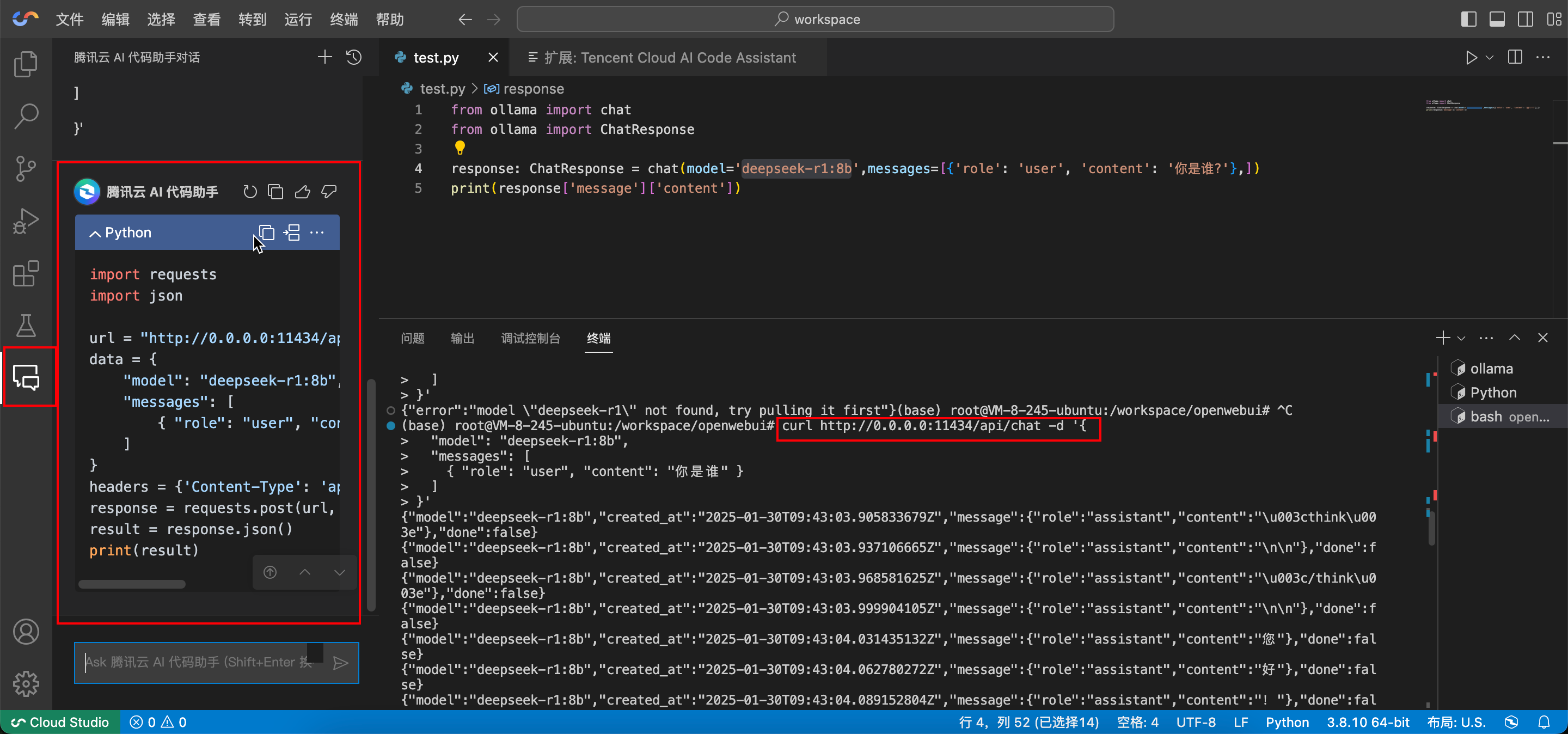

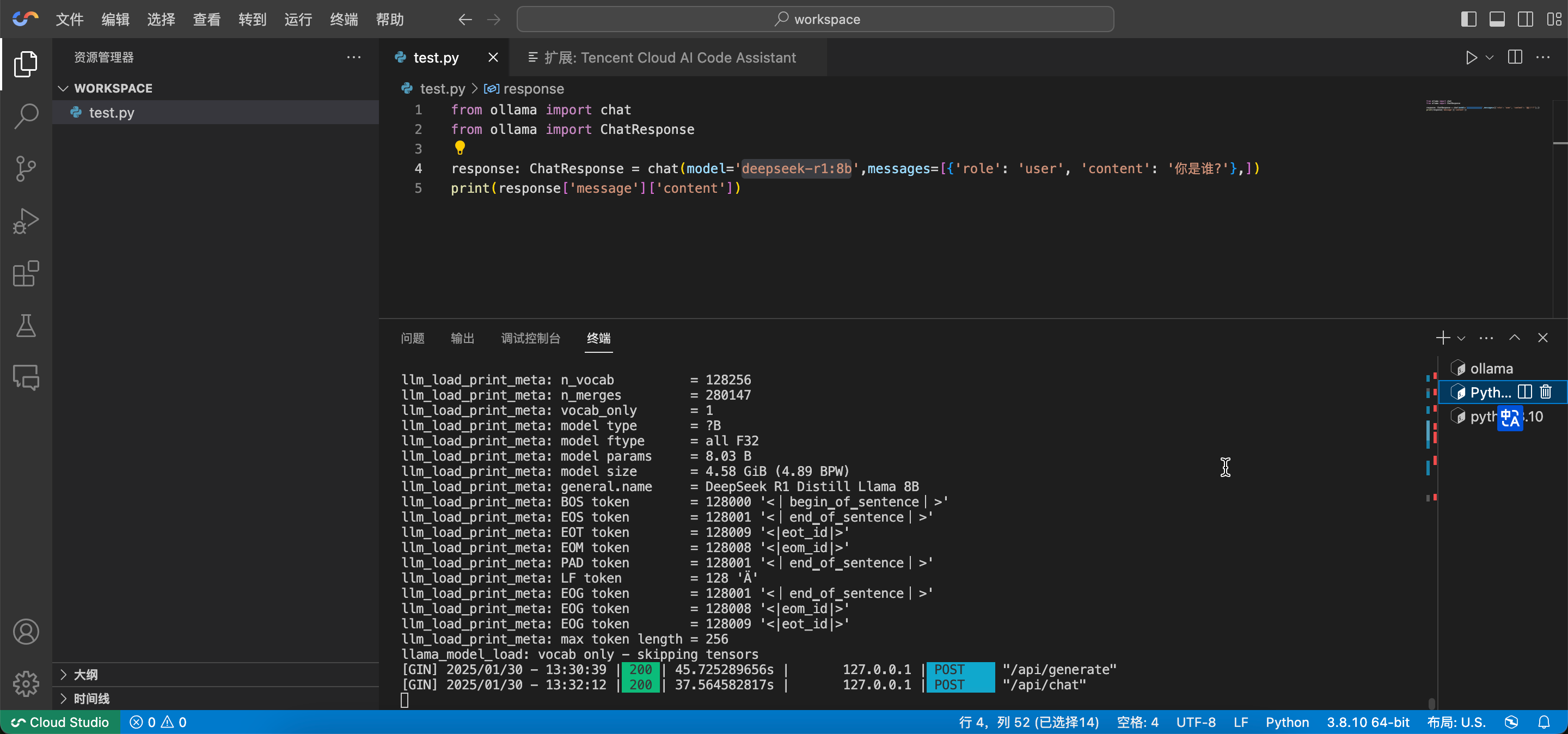

腾讯云编辑器自带的“AI 代码助手”给我们生成一个调用“deepseek-r1”的程序例,例如我们可以用 ai 助手这么问:

我现在已经用ollama本地部署了deepseek-r1的大模型,现在写一段测试代码,直接通过ollama调用本地大模型环境,输入 “你是谁”,并生成结果,格式是这样的 curl http://0.0.0.0:11434/api/chat -d '{

"model": "deepseek-r1:8b",

"messages": [

{ "role": "user", "content": "你是谁" }

]

}'

import requests

import json

url = "http://0.0.0.0:6399/api/chat"

data = {

"model": "deepseek-r1:8b",

"messages": [

{ "role": "user", "content": "你是谁" }

]

}

headers = {'Content-Type': 'application/json'}

response = requests.post(url, data=json.dumps(data), headers=headers)

result = response.json()

print(result)

- http 接口服务

# 调用生成接口

curl http://0.0.0.0:6399/api/generate -d '{

"model": "deepseek-r1:8b",

"prompt": "你是谁"

}'

# 调用聊天接口

curl http://0.0.0.0:6399/api/chat -d '{

"model": "deepseek-r1:8b",

"messages": [{ "role": "user", "content": "你是谁" }]

}'

- ollama 常用命令

# 启动 Ollama 服务,是后续操作的基础。

ollama serve

# 从模型文件创建模型,适用于自定义模型或本地已有模型文件的情况。

ollama create

# 显示模型信息,可查看模型架构、参数等详细信息,辅助模型分析。

ollama show

# 运行模型,例如运行名为 'qwen2' 的模型,若本地无该模型会自动下载并运行,可用于快速测试模型。

ollama run qwen2

# 从注册表中拉取模型,例如拉取名为 'llama3' 的模型,方便获取官方或其他来源的模型。

ollama pull llama3

# 将模型推送到注册表,便于共享模型。

ollama push

# 列出本地已有的模型,方便管理和选择。

ollama list

# 复制模型,可用于备份或创建模型副本。

ollama cp

# 删除模型,释放存储空间。

ollama rm

# 获取任何命令的帮助信息,方便用户快速查询命令用法。

ollama help

1.2. 内网穿透对外提供服务

1.2.1. 内网穿透暴露到公网

# 安装工具包

apt update && apt install lsof -y

pip install gradio-tunneling gradio

# 查看 ollama 端口

lsof -i -P -n | grep "ollama"

# 启动内网穿透(注意替换为你的ollama端口)

/root/miniforge3/bin/gradio-tun --port 6399

# 自动配置内网穿透端口

PORT=$(lsof -i -P -n | grep "ollama" | awk '{print $9}' | cut -d':' -f2) && /root/miniforge3/bin/gradio-tun --port $PORT

公网访问地址:https://***.gradio.live

这个共享链接将在 72 小时后过期,此程序将在 72 小时后关闭。

# 每天0点自动重启

crontab -e

0 0 * * * /root/miniforge3/bin/gradio-tun --port 6399

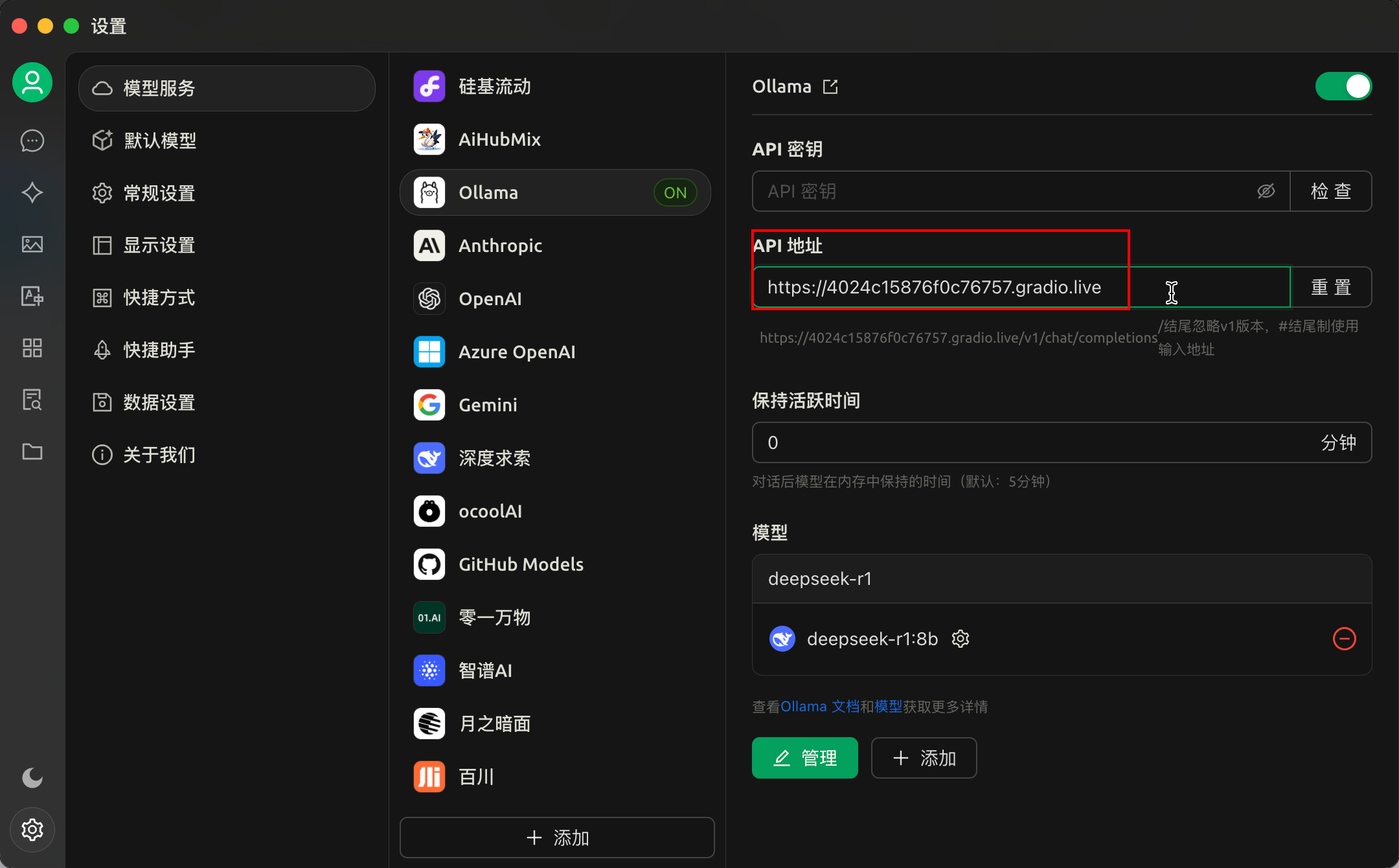

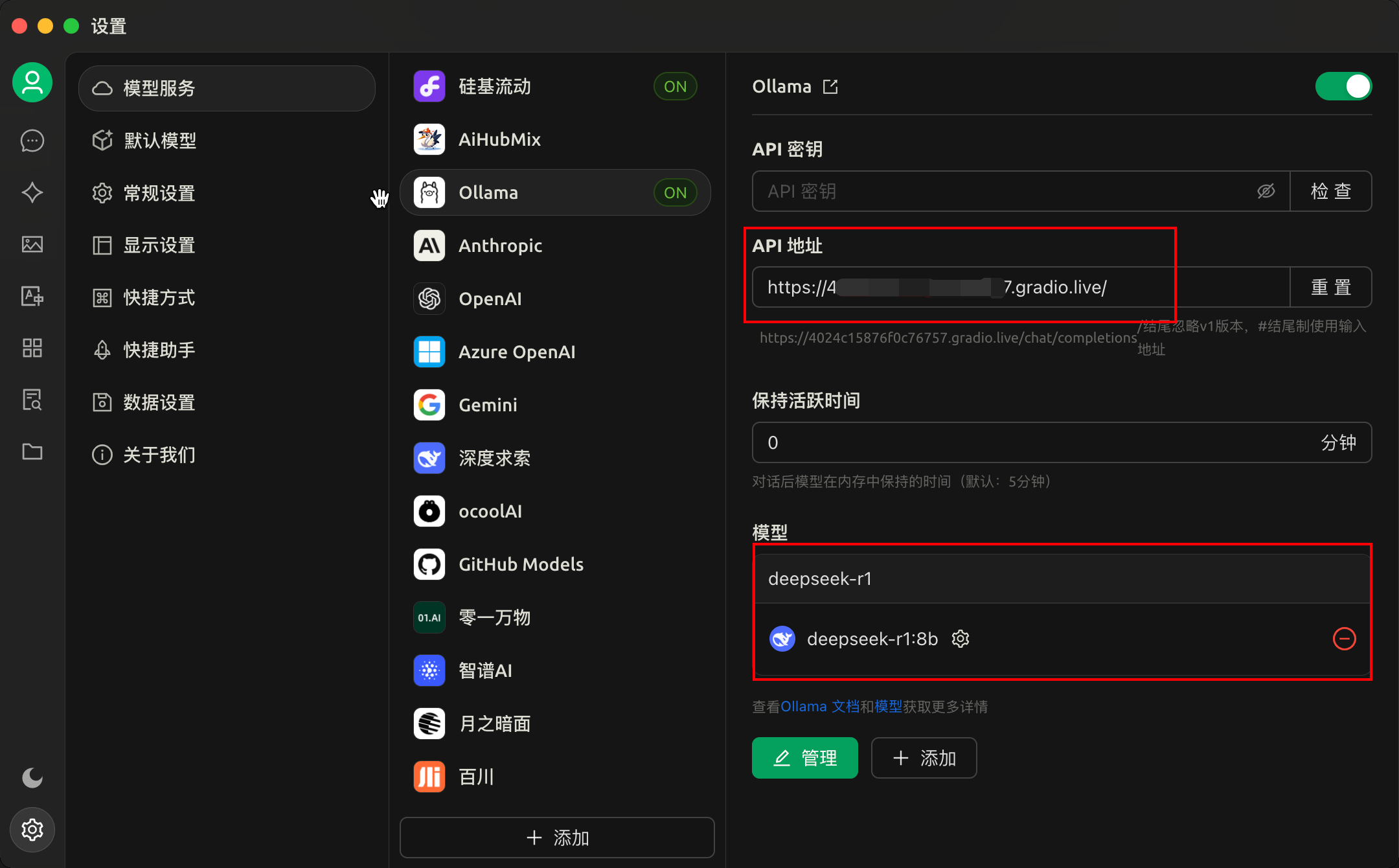

1.2.2. 电脑/手机/网页访问该模型

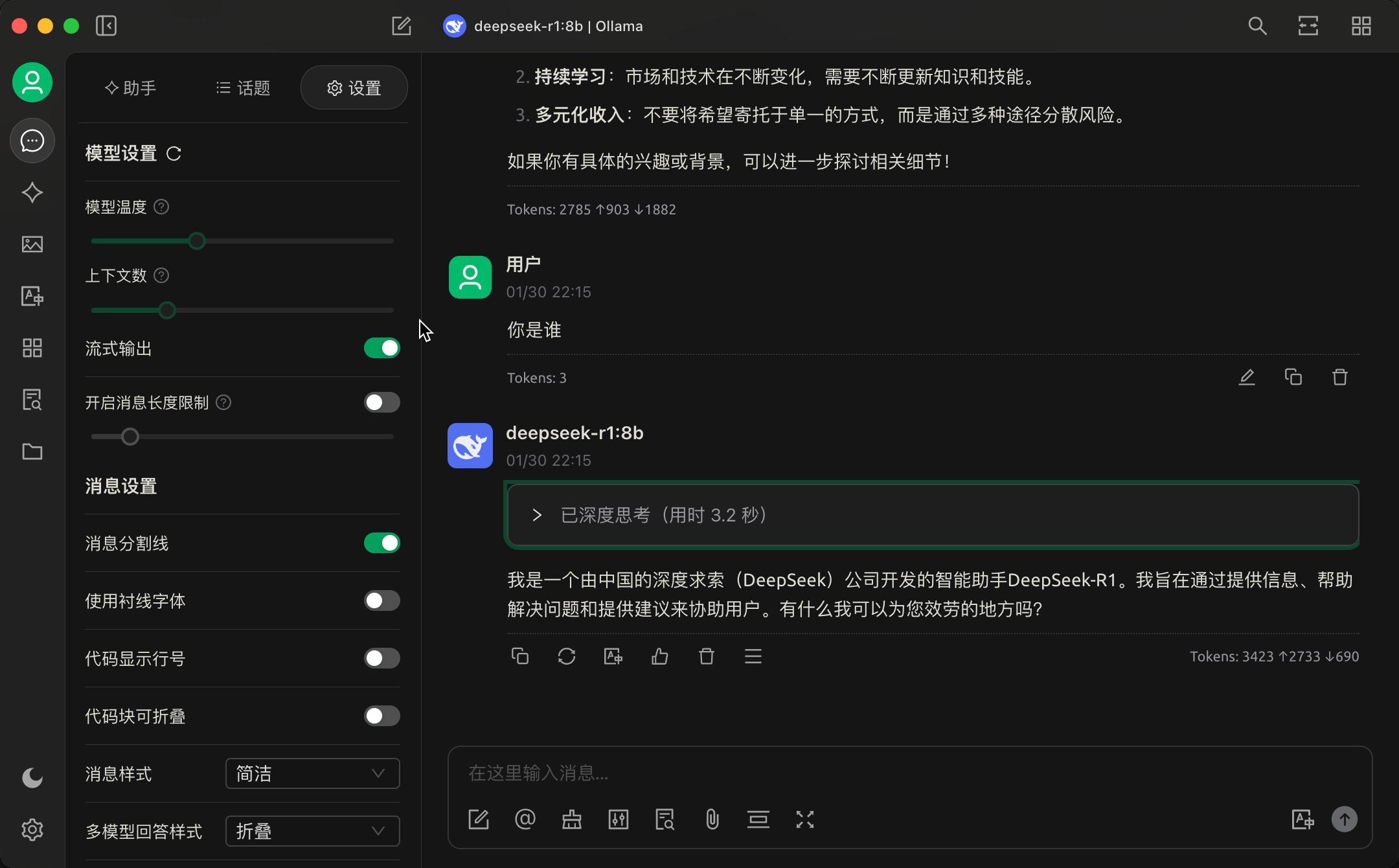

- 电脑端

例如可以使用Cherry Studio这种服务,配置自己 AI 模型就能提供对外服务.

本地模型无需填写 API 秘钥,其余地址按照提示填写,如图所示:

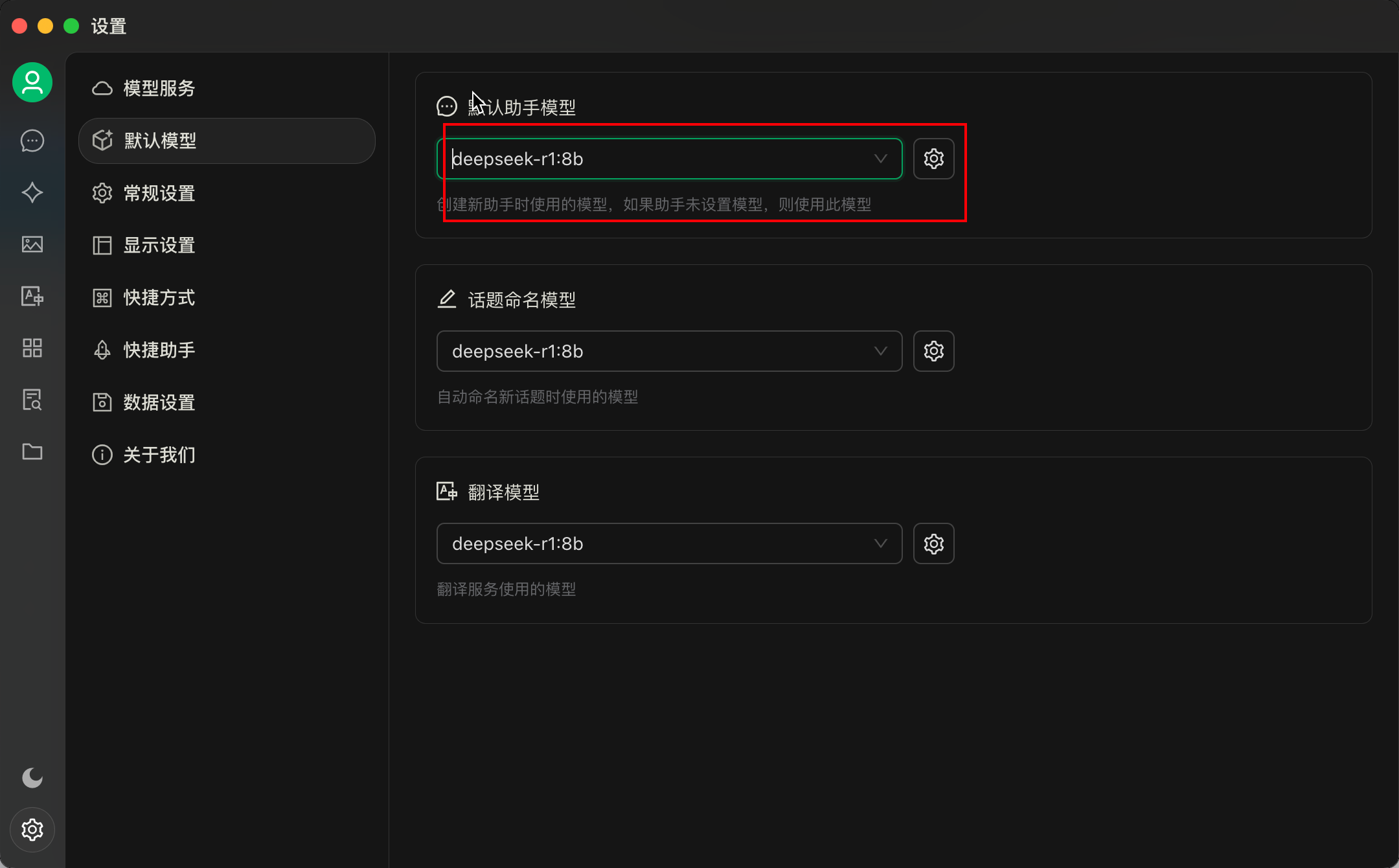

默认模型选择刚才配置的自定义模型deepseek-r1:8b

对话中测试"你是谁?"

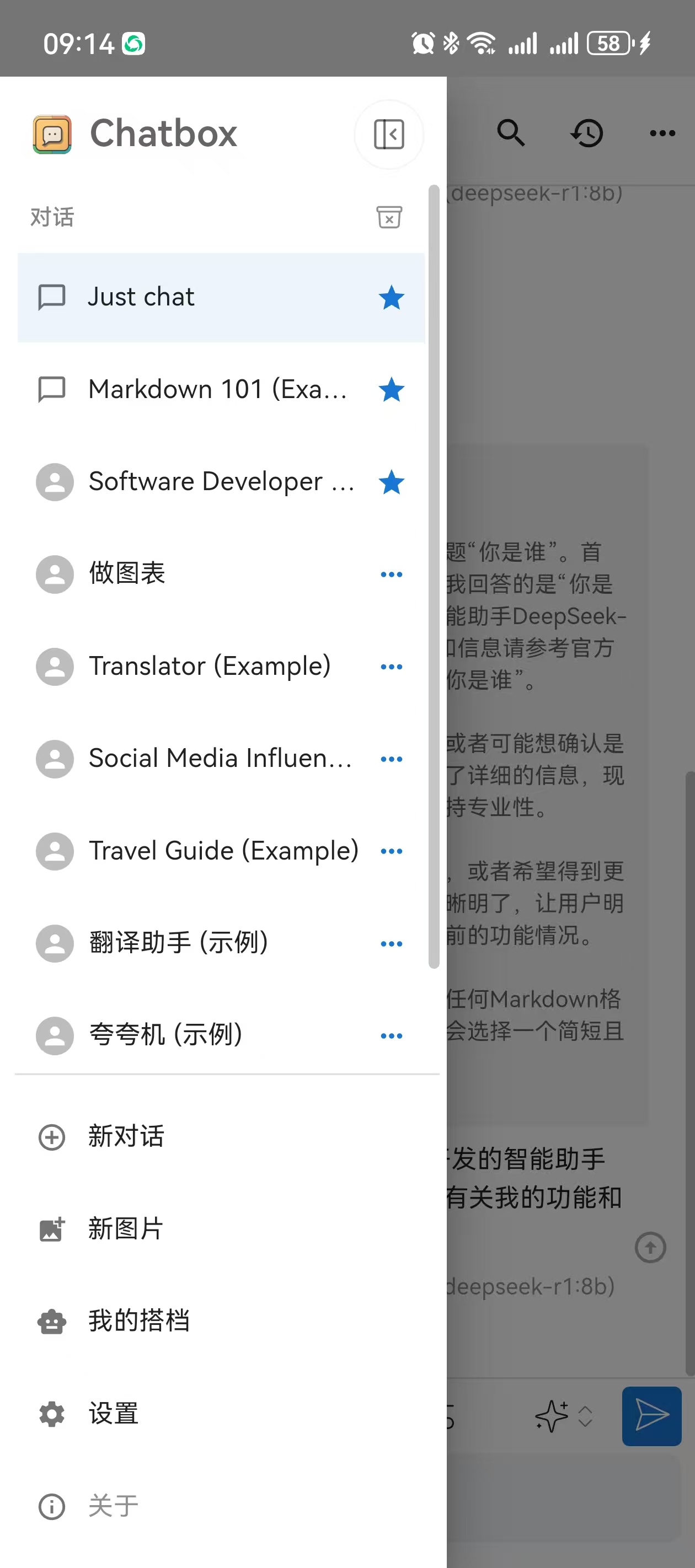

- 移动端

或者Chatbox 是一款 AI 客户端应用和智能助手,支持众多先进的 AI 模型和 API,可在 Windows、MacOS、Android、iOS、Linux 和网页版上使用.

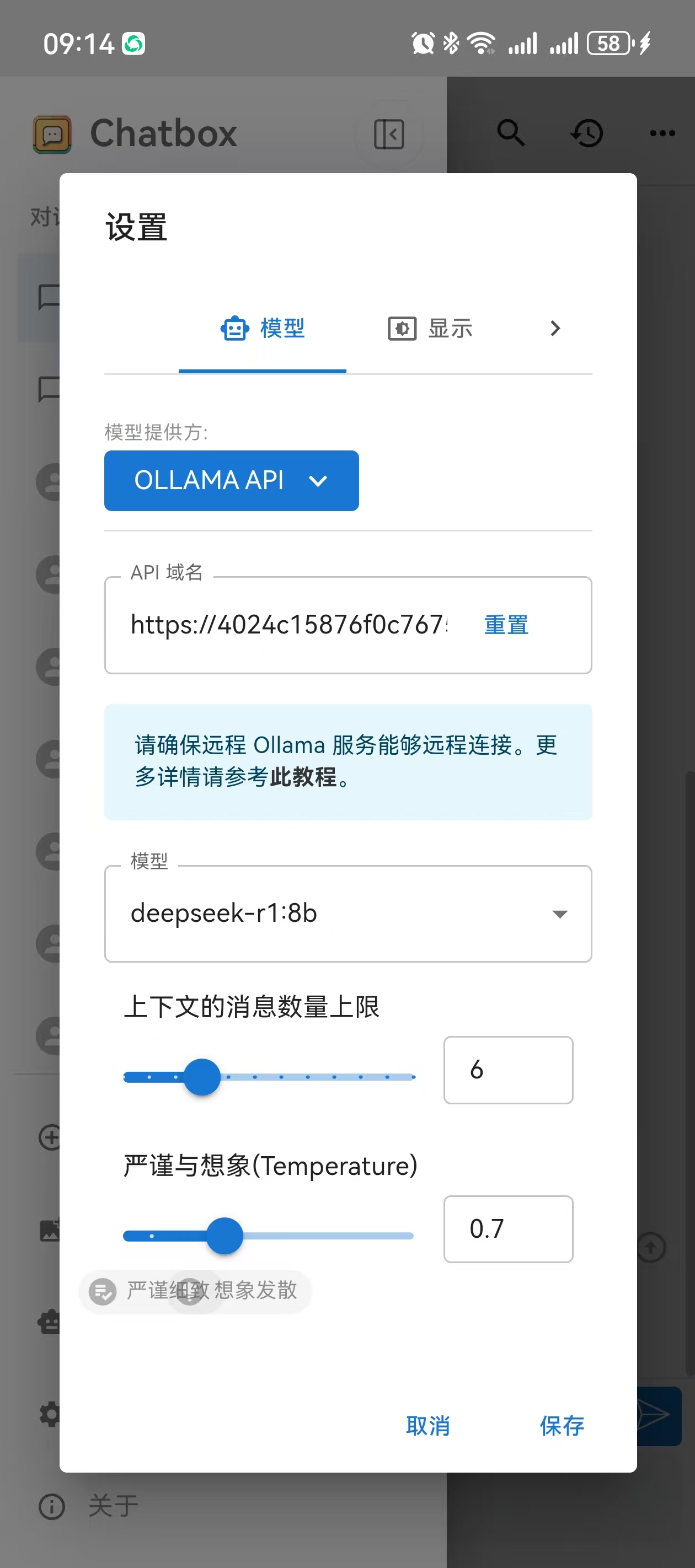

左下角设置:

模型提供方选择 OllamaApi:

填写 api 域名以及模型名称(

deepseek-r1:8b)

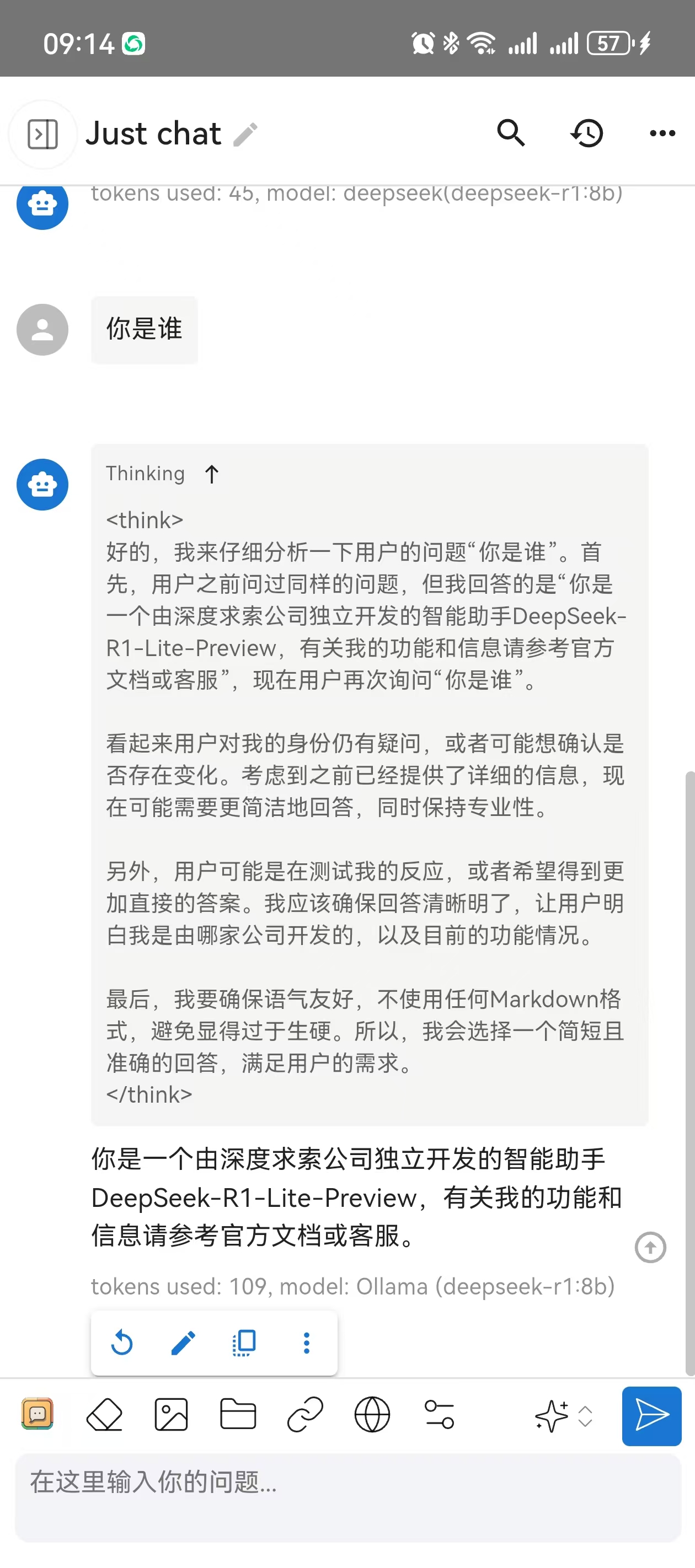

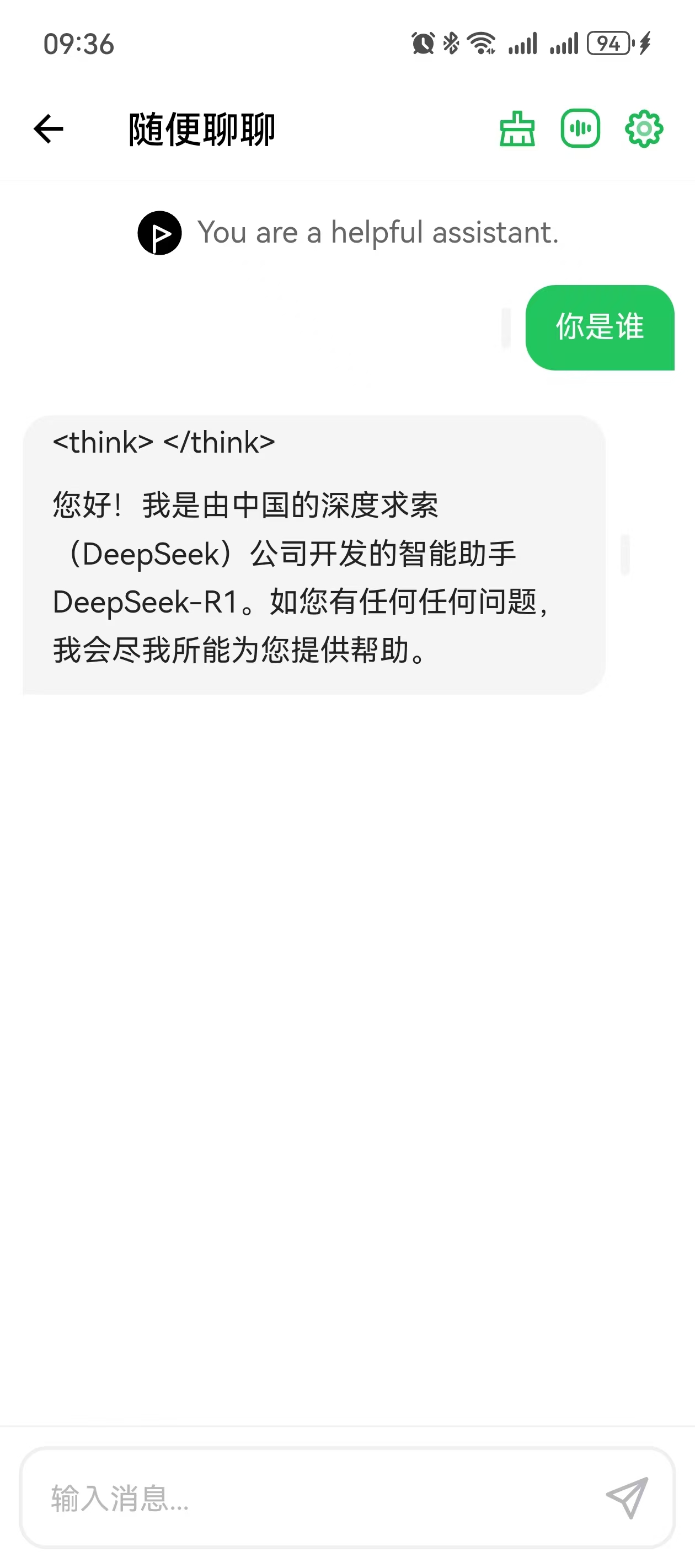

聊天对话框就能调用该模型:

- 类似推荐

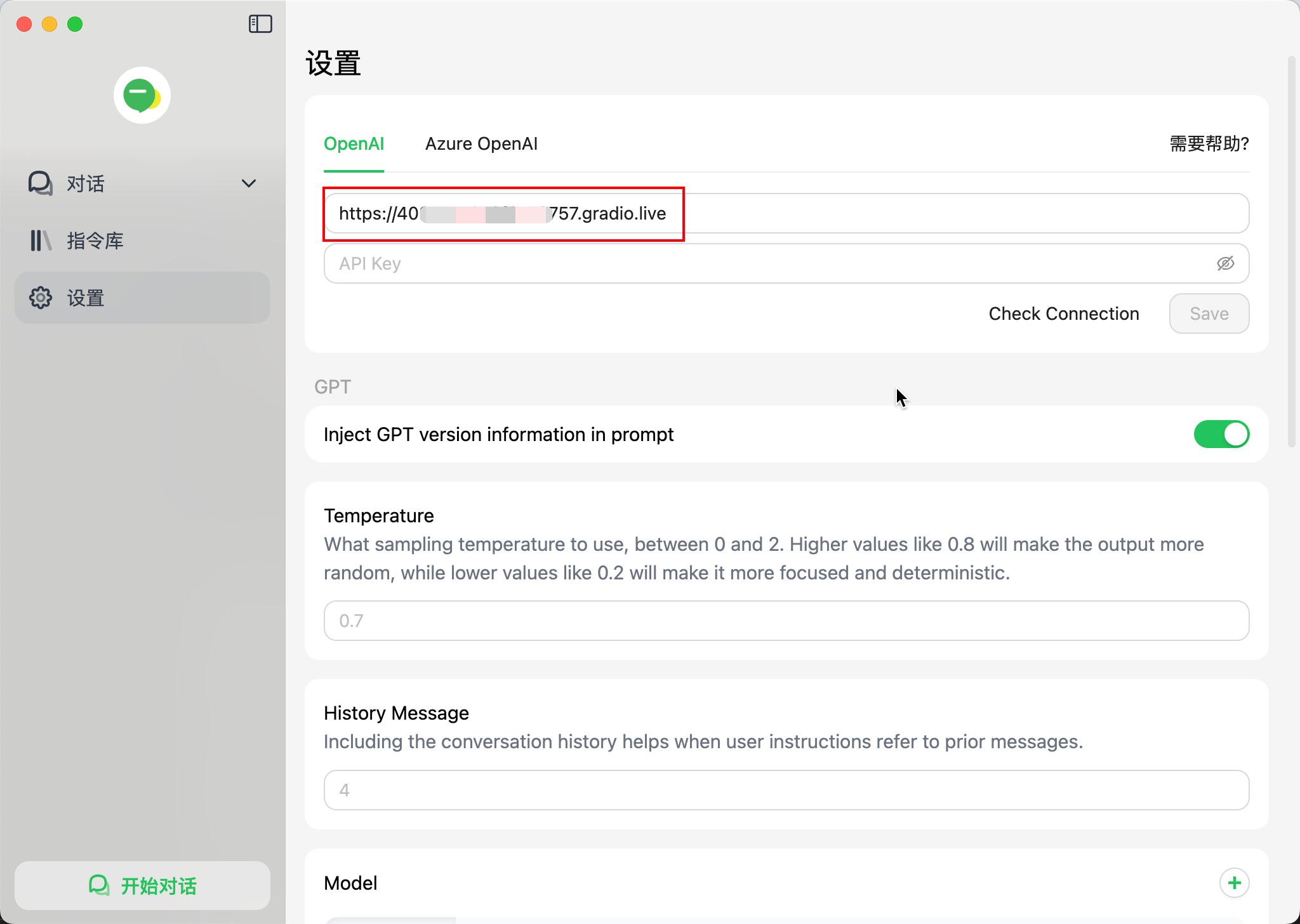

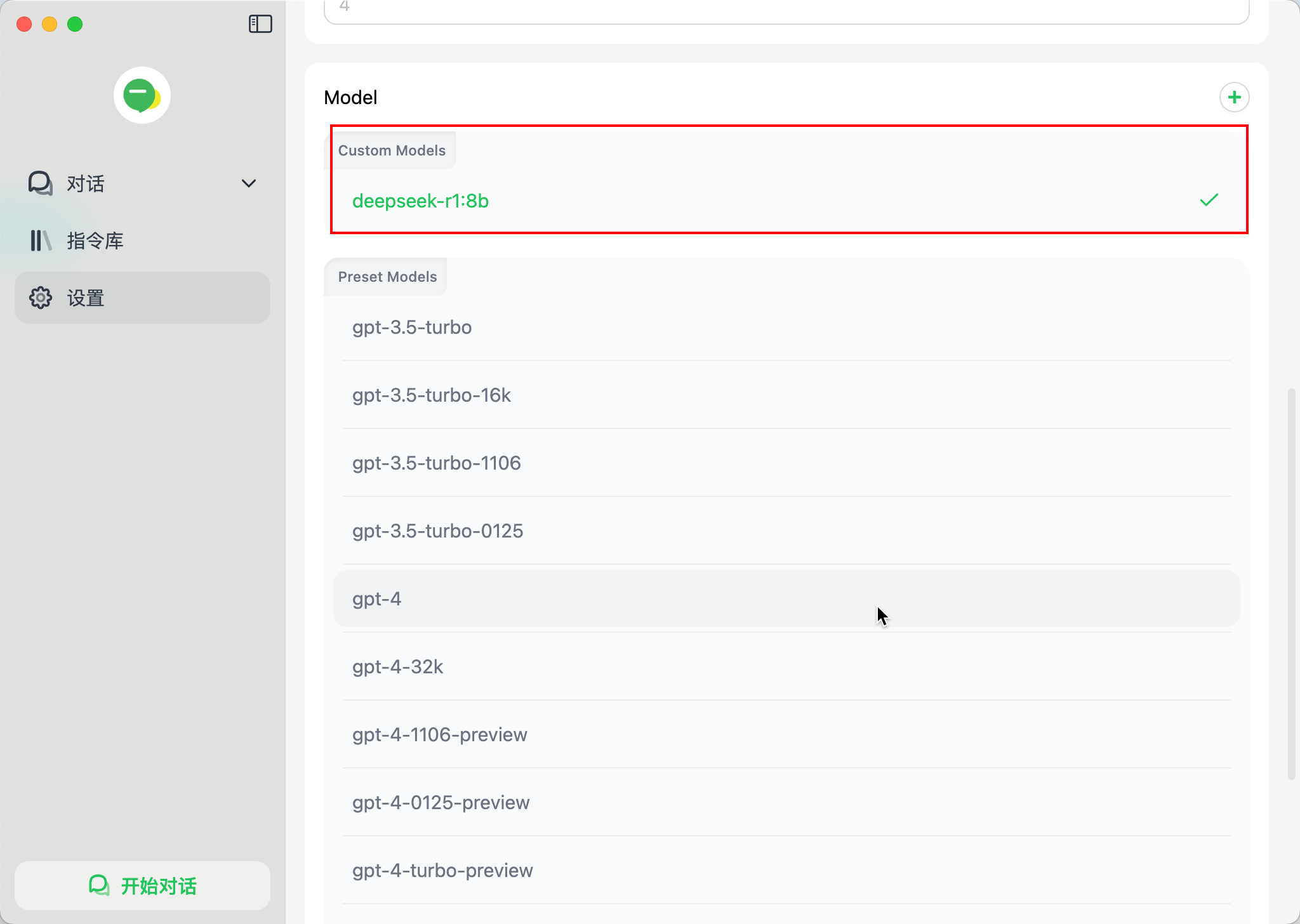

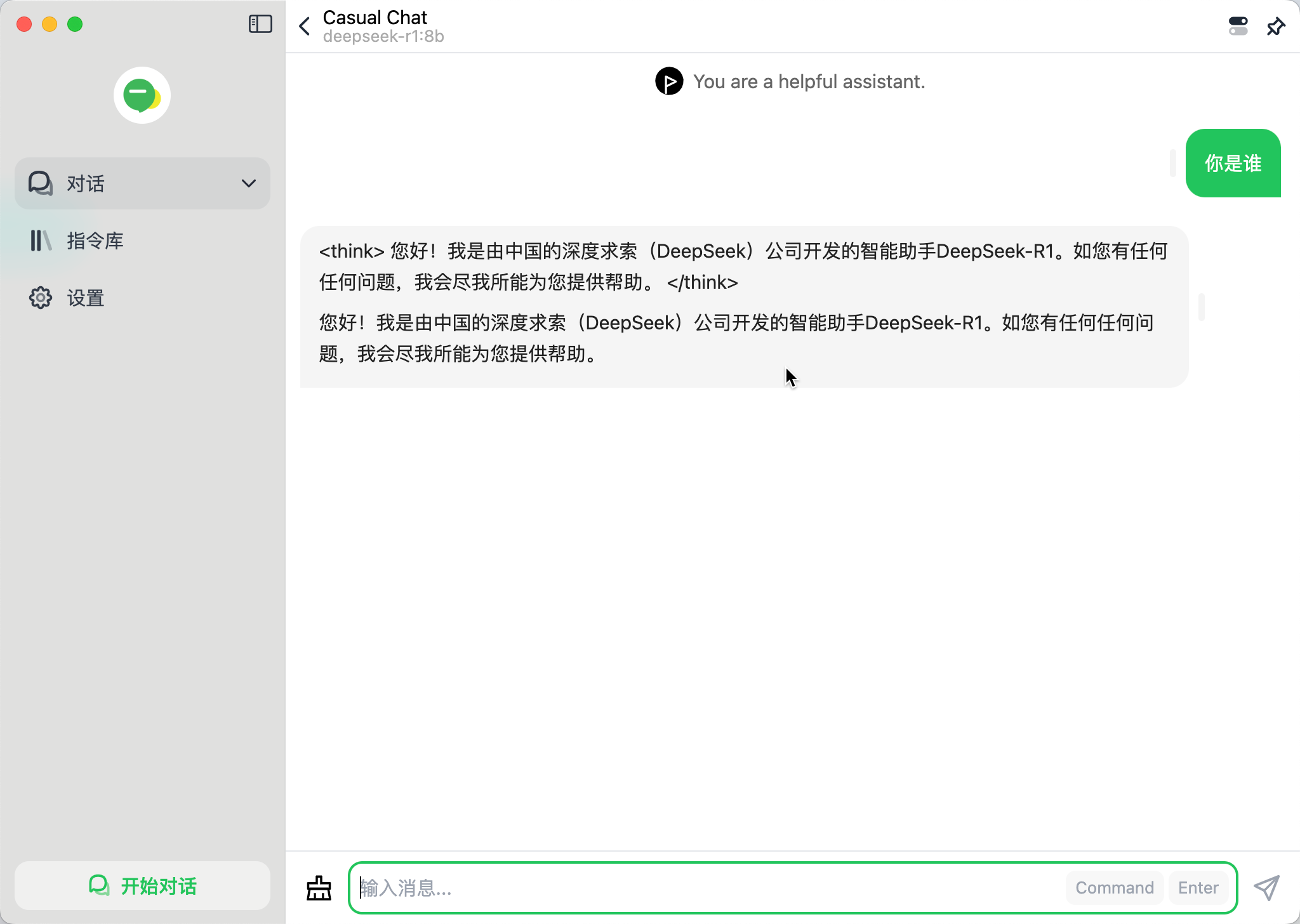

电脑端演示如下:

官网地址: BotGem

同样的设置 api 域名:

设置模型名称:

开始对话测试:

手机端演示如下:

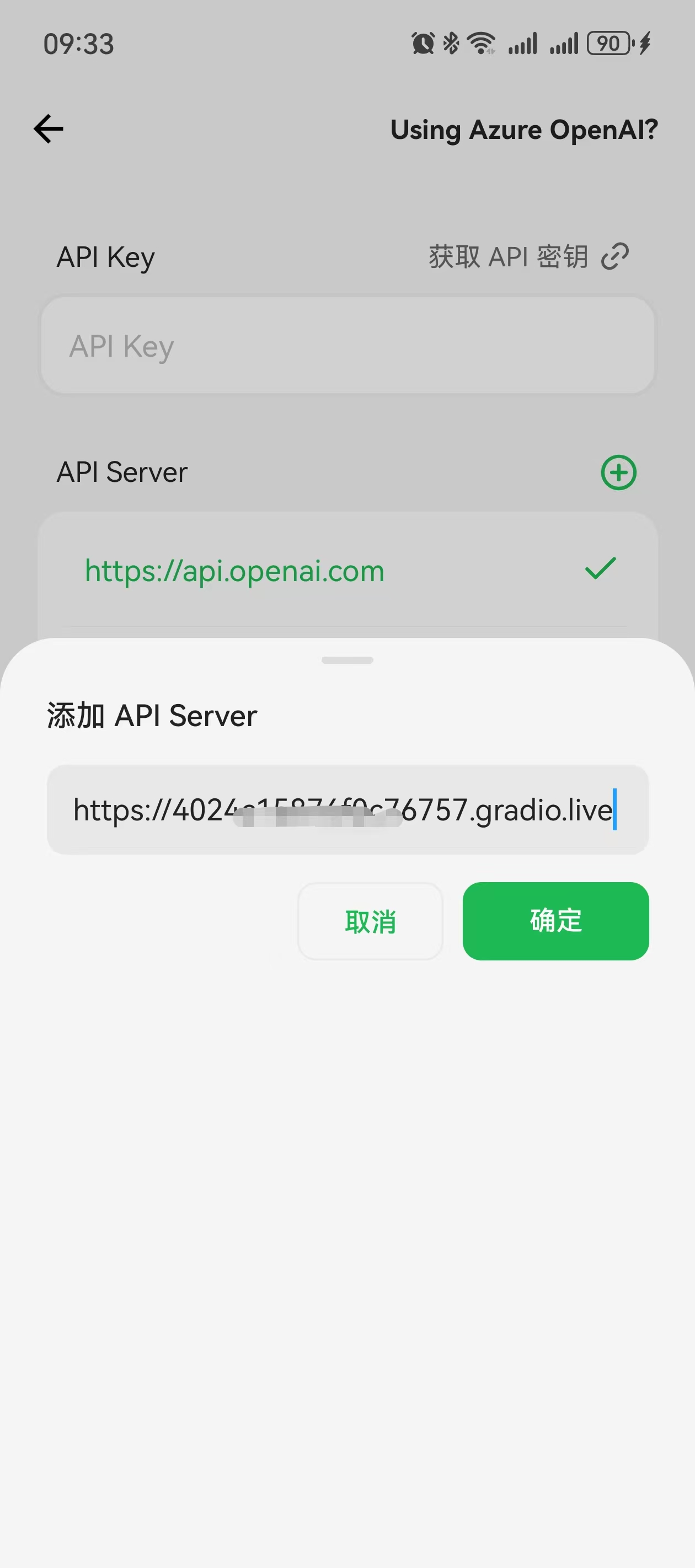

第一步: 底部操作栏设置 > OpenAI 设置: 设置 api 域名

添加 API Server

添加成功后再次点击该域名,选中后使用该 api 地址 :

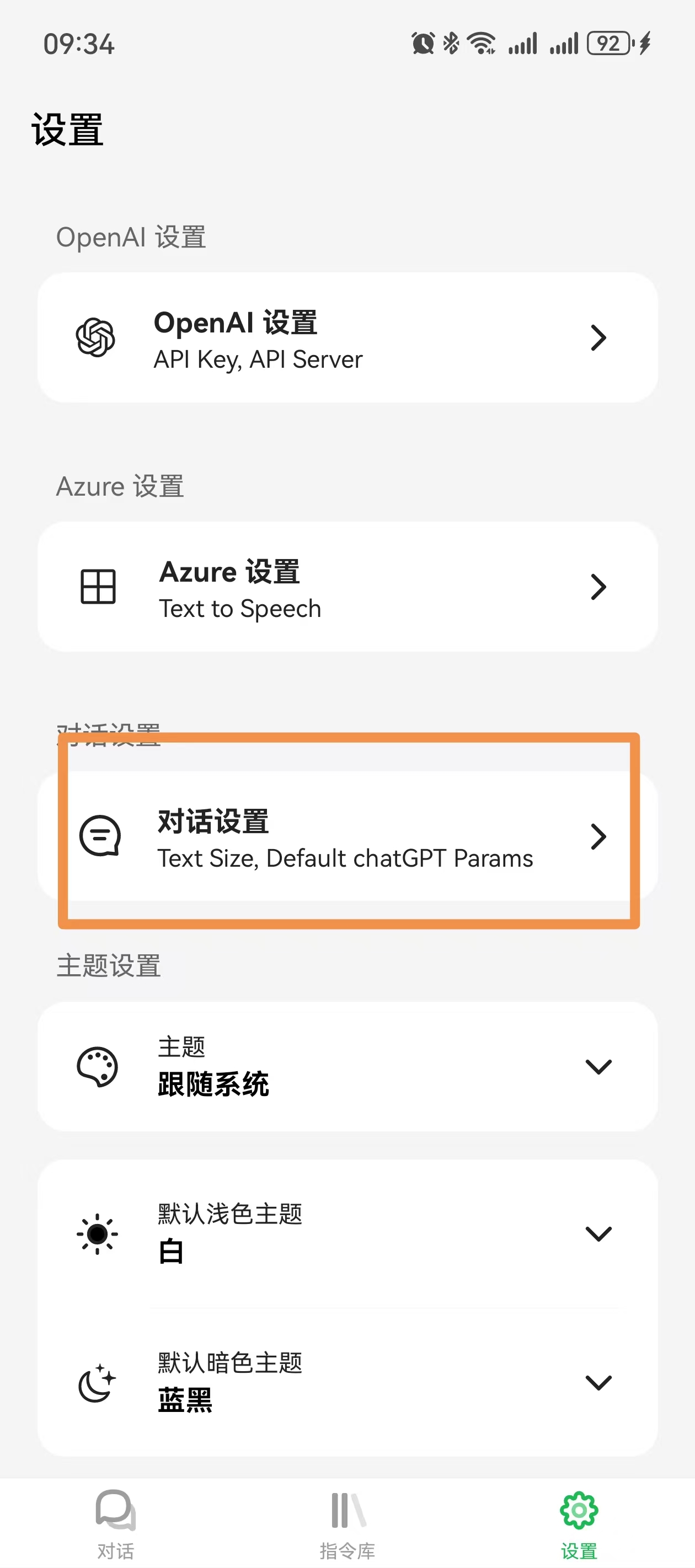

第二步: 底部操作栏设置 > 对话设置: 设置模型名称

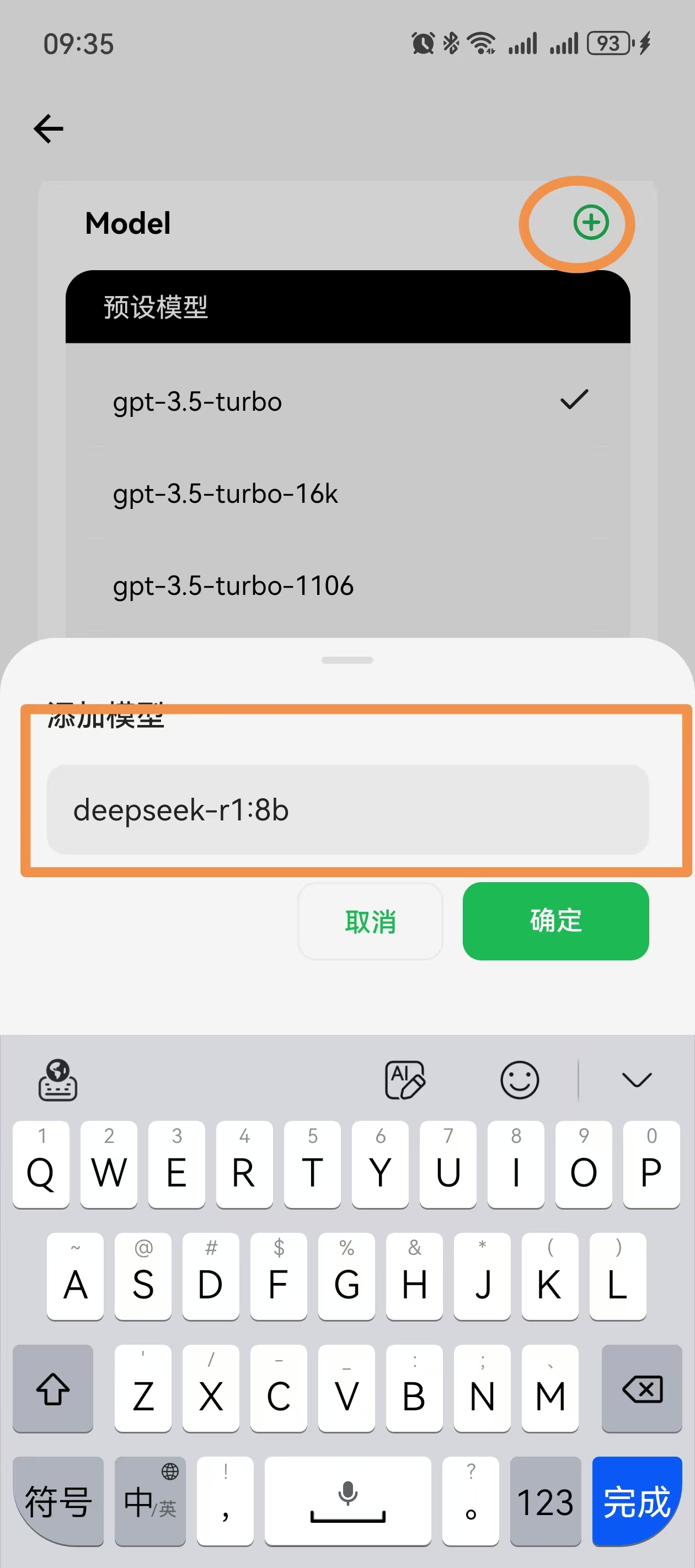

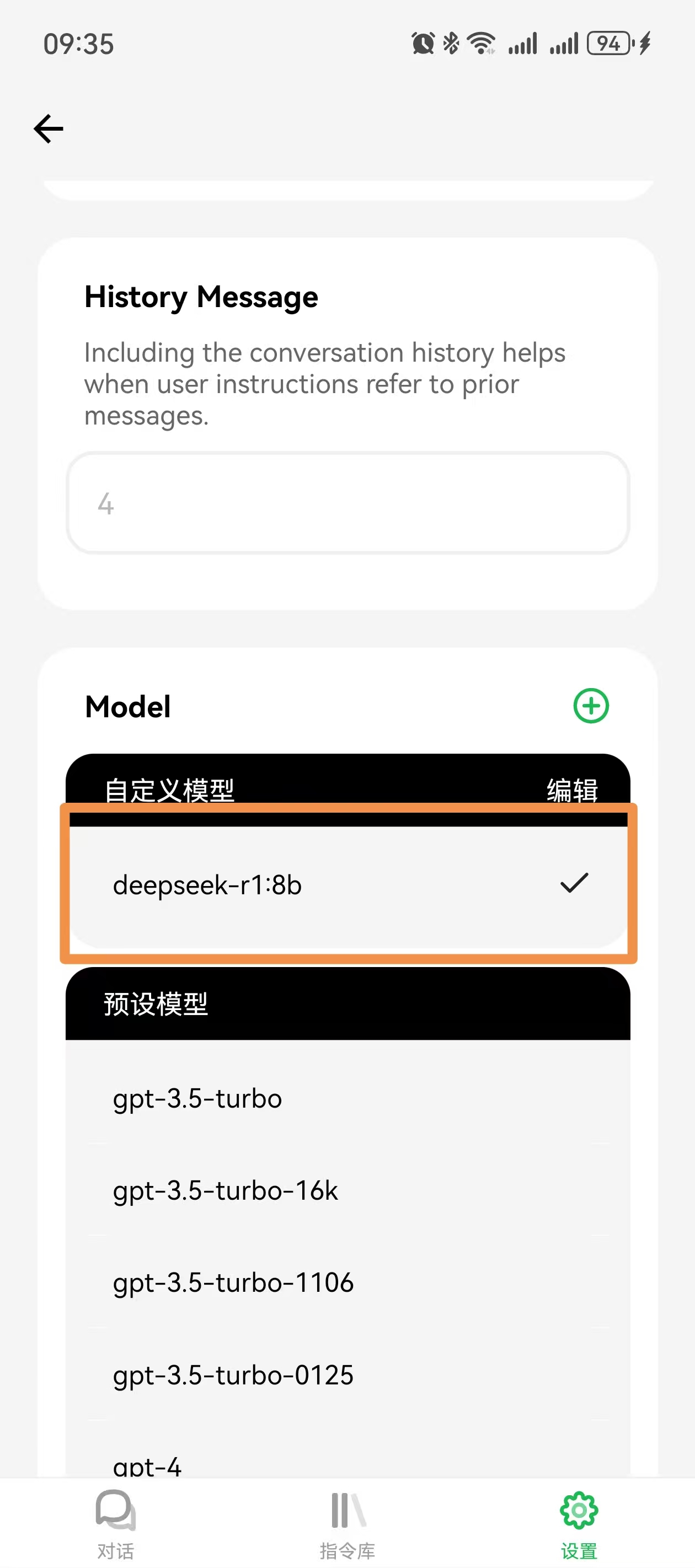

同样的,添加自定义模型名称:

再次点击选中后使用该模型:

第三步: 开始对话

1.3. 总结

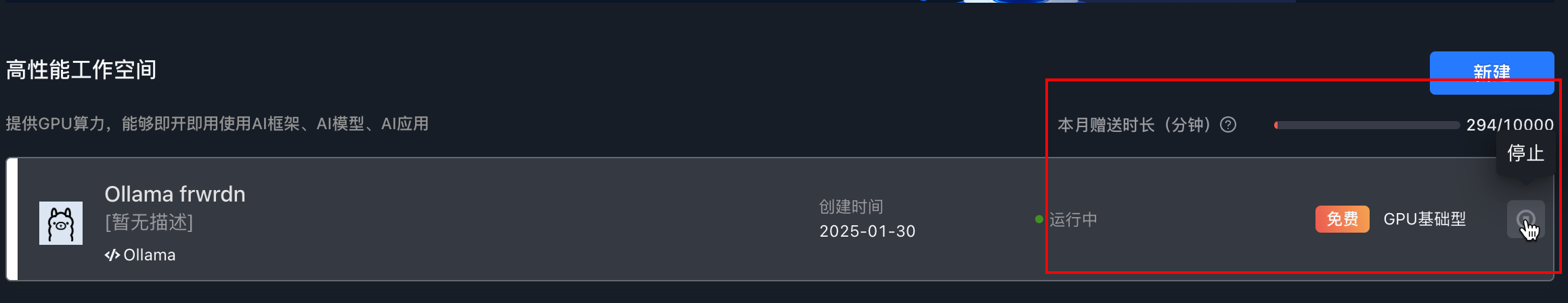

本文主要介绍了本地已部署了 AI 大模型的后续操作,首先通过开启远程访问端口,再利用内网穿透技术暴露到公网,对外提供了 api 服务.

然后,将上述得到的公网地址和模型名称整合到第三方 ai 应用就能实现自己的 ai 对话客户端,介绍了三款相关应用,推荐第一个Cherry Studio颜值好看!

新年快乐!

愿新的一年带给您健康、幸福和财运亨通!无论是通过投资、创业、副业,还是其他让人发财的方法,愿每一位阅读过文章的朋友都能在这一年里实现自己的财务目标,收获满满!祝愿您在新的一年里,事业蒸蒸日上,生活如意!

tips:虽然每个月赠送 1 万分钟,但是 24 小时开机基本维持一周左右.

如果用完之后,可以回到首页直接点击关机即可!

1.4. 推荐

- DeepSeek 这个春节也太火爆了,现在就教你如何私有化部署云端 AI 大模型!

- 免费制作红包封面还得是 AI 生成,附赠 AI 智能体提示词

- python 源码-好宝贝母婴每日签到赚积分

- 良心活动,无需实名,直接照抄答案就行,懂点 python 就能每天白嫖现金红包

- 懒人速成一分钟教你私人定制专属红包封面

- C 盘爆满飘红不用怕,教你三招搞定它,轻松释放几十 G 的磁盘空间!

- Mac 版本 Burpsuite 下载安装超详细教程,专业版中文激活教程(附下载)

- Burpsuite 下载安装超详细教程,社区版永久有效,专业版汉化激活到 2099 年,不看会后悔系列,亲测好用!

- 终极防窥秘籍!禁用右键+F12,竟还拦不住好奇宝宝?揭秘防窥新境界!

- 【硬核防白嫖秘籍】一键取关?直接拉黑,让你的公众号再无回头白嫖党!

- 谁家爬虫这么明目张胆?连 UserAgent 都不要了!

1.5. 关注

欢迎扫码关注,私信回复『加群』一起交流技术

作者: 雪之梦技术驿站

来源: 雪之梦技术驿站

本文原创发布于「雪之梦技术驿站」,转载请注明出处,谢谢合作!