1. 私有化部署deepseek服务

声明:该公众号大部分文章来自作者日常学习笔记,也有部分文章是经过作者授权和其他公众号白名单转载.

未经授权,严禁转载,如需转,联系开白.

请勿利用文章内的相关技术从事非法测试,如因此产生的一切不良后果与文章作者和本公众号无关.

现在只对常读和星标的公众号才展示大图推送,建议大家把「雪之梦技术驿站」“设为星标”,否则下次可能看不到了!

1.1. 引言

春节这两天国产AI deepseek 大模型又给我们大大的震撼!

遭受了大规模的网络宕机服务,无法体验,得益于开源可以私有化部署!

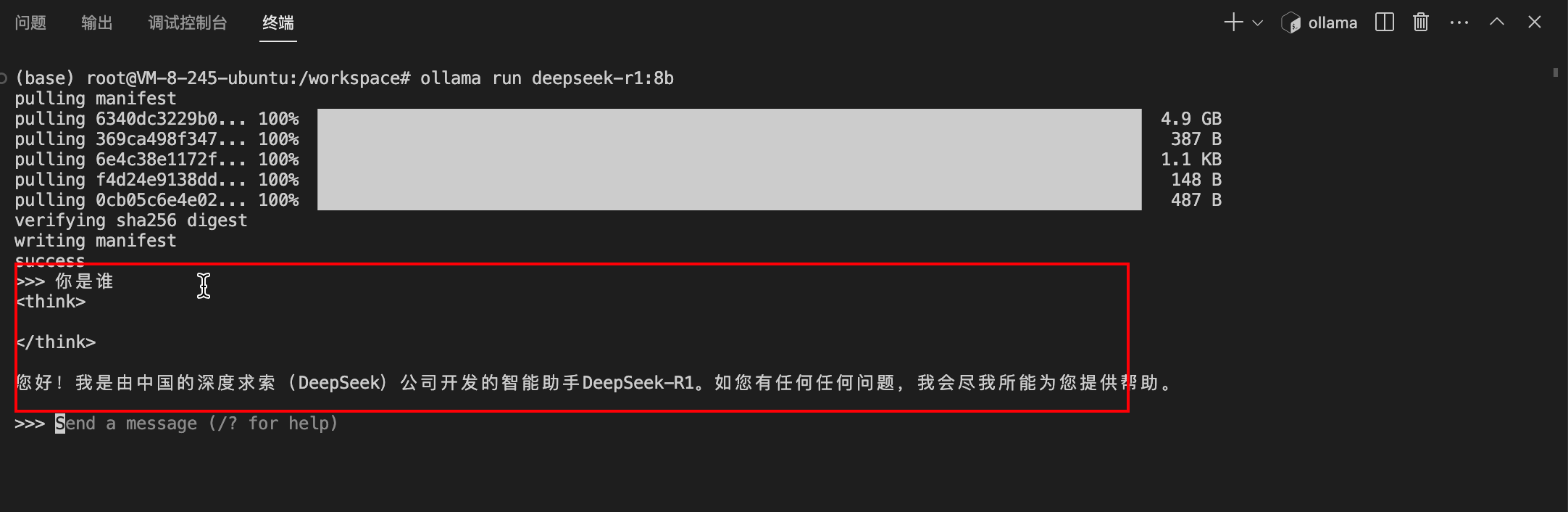

下面就基于腾讯云教你如何部署自己的开源大模型,跟着教程来,你也能问问: "你是谁?"

您好!我是由中国的深度求索(DeepSeek)公司开发的智能助手DeepSeek-R1。如您有任何任何问题,我会尽我所能为您提供帮助。

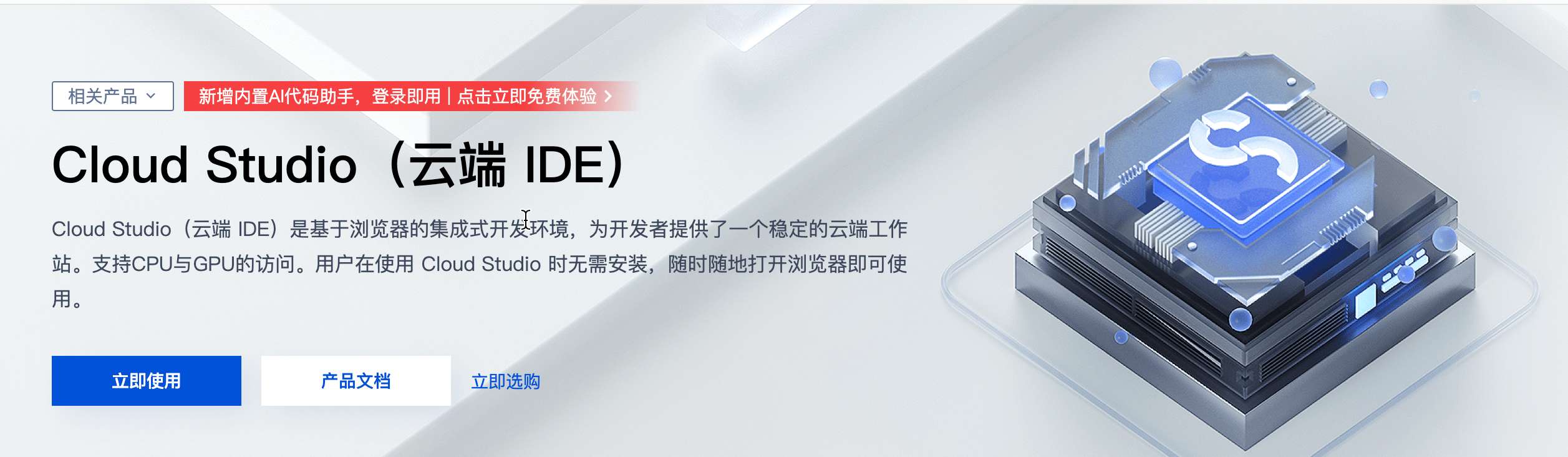

1.2. 注册并登录腾讯云 Cloud Studio

首先您需要注册一个腾讯云账号(点击阅读原文即可注册).

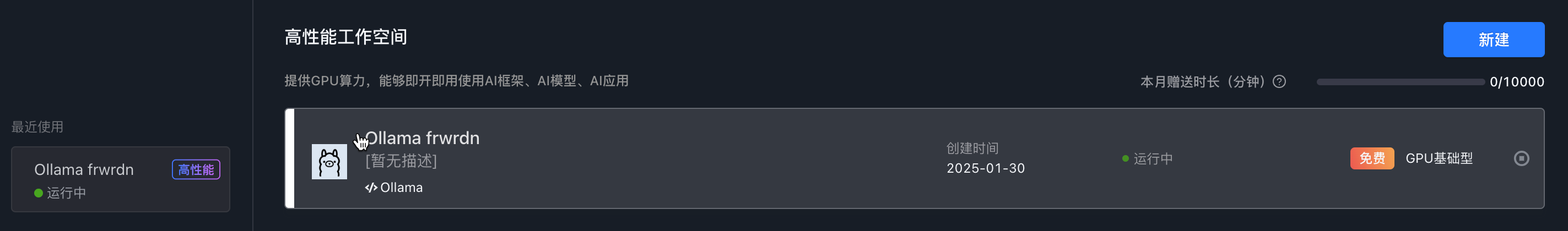

然后登录腾讯云 Cloud Studio,每月免费时长10000分钟的 GPU 算力资源,配置为 16G 显存,32G 内存和 8 核 CPU,足以满足大多数开发需求.

1.3. 部署 DeepSeek R1 AI 模型

1.3.1. 终端交互

- 第一步: 新建

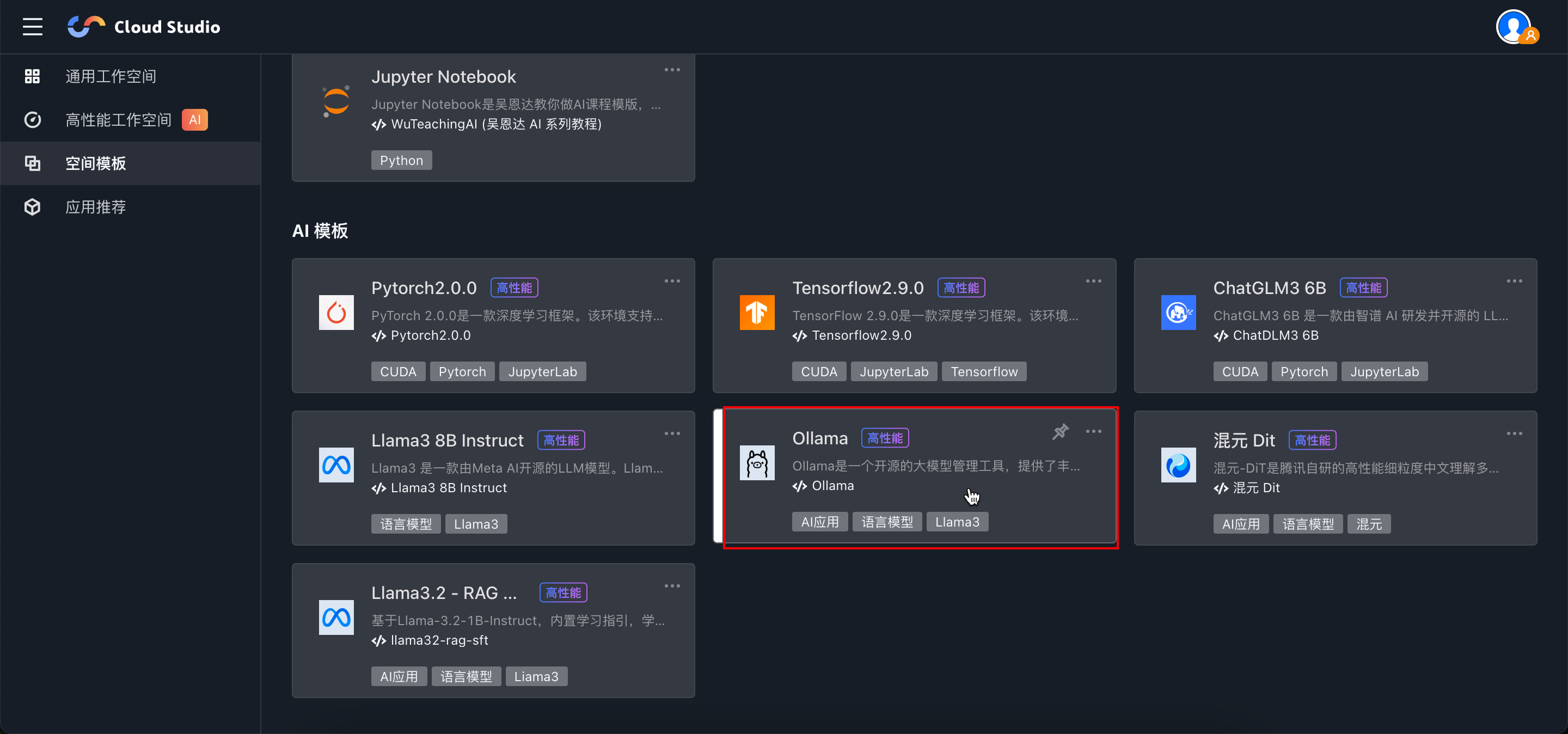

Ollama模版

开始创建工作控件 > 模版创建 > 选择 Ollama 模板

选择基础型的体验套餐 > 新建

- 第二步: 下载

deepseek-r1:8b模型

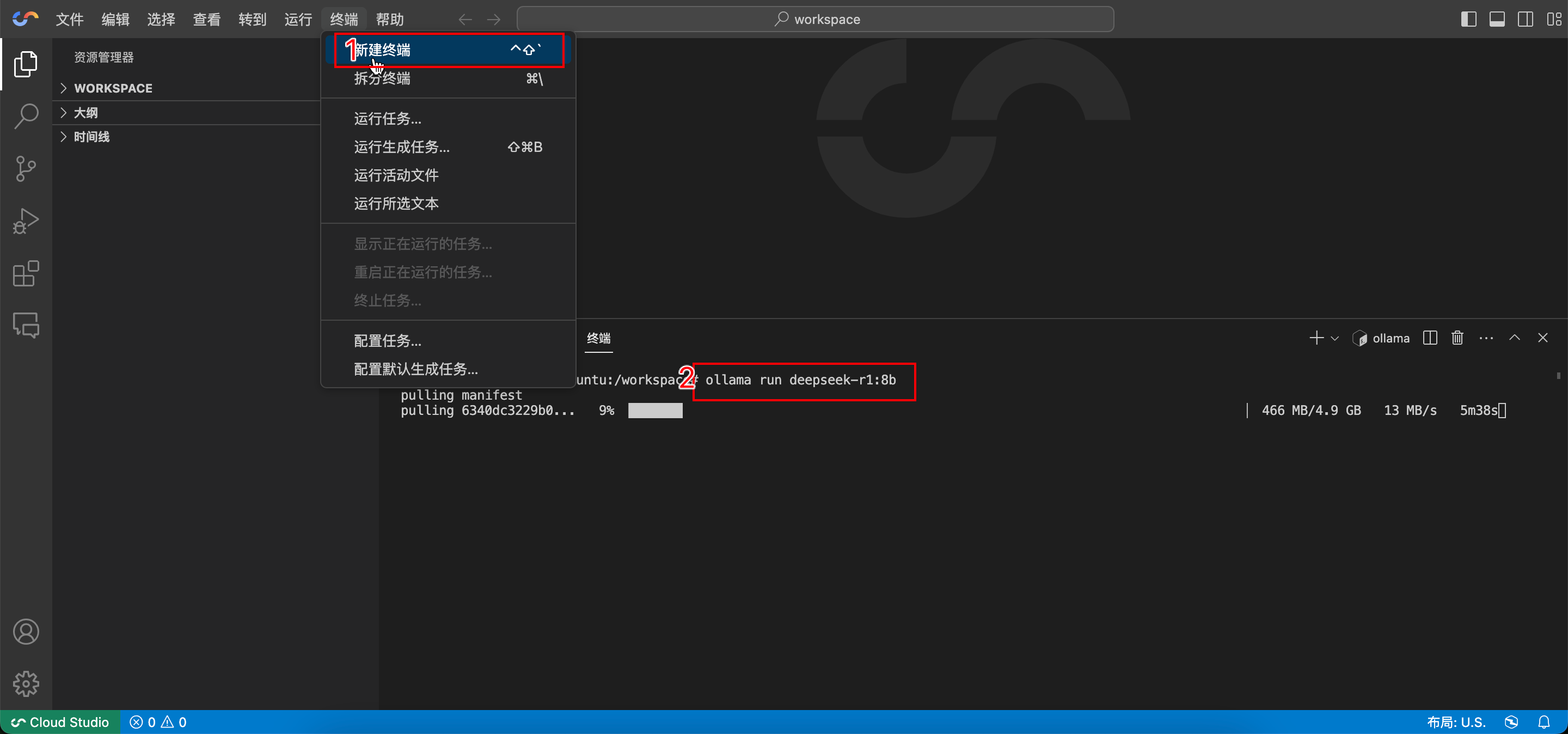

点击工作空间进入云端编辑器,打开终端输入命令: ollama run deepseek-r1:8b 部署 DeepSeek R1 模型.

等待模型下载完成后, Ollama 会自动启动 DeepSeek R1并进入交互模式.

- 第三步: 终端交互

此时,您可以在终端中直接输入问题或指令,与DeepSeek R1进行对话,体验其强大的语言理解和生成能力。

1.3.2. 编程交互

经过上一步我们已经在本地部署好了大模型服务,通过python编程方式交互.

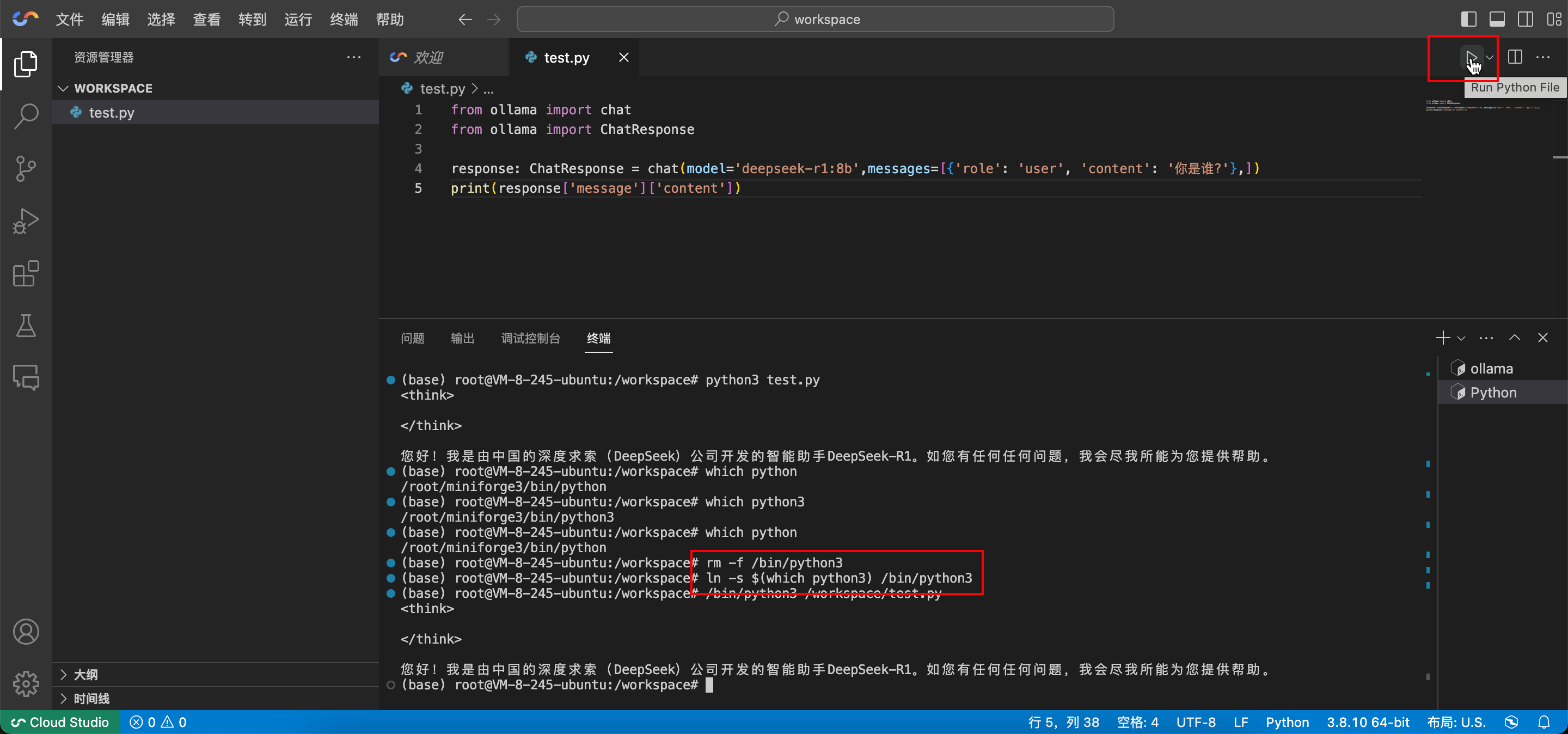

- 第一步: 配置

ollama环境

pip3 install ollama

- 第二步: 配置

Python环境

在终端中配置系统默认的 Python 解释器:

rm -f /bin/python3

ln -s /root/miniforge3/bin/python3 /bin/python3

ln -s $(which python3) /bin/python3

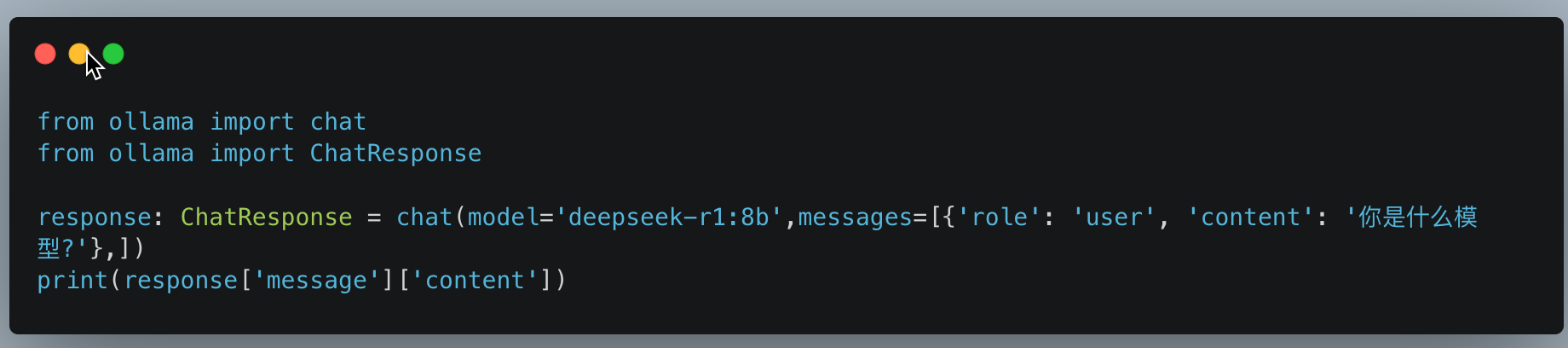

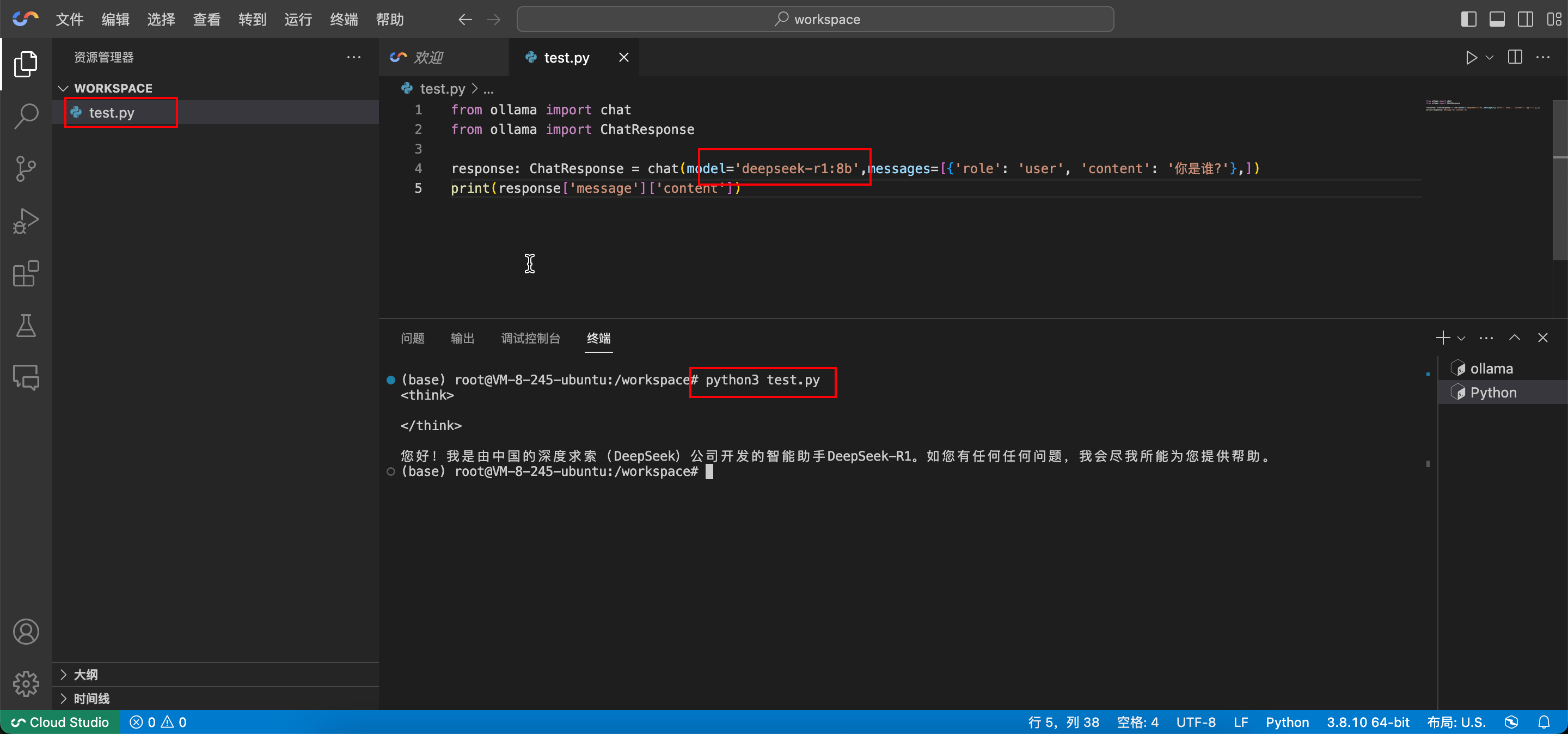

- 第三步: 新建测试文件

test.py

在编辑器中点击运行或者在终端命令行中运行: python3 test.py

from ollama import chat

from ollama import ChatResponse

response: ChatResponse = chat(model='deepseek-r1:8b',messages=[{'role': 'user', 'content': '你是谁?'},])

print(response['message']['content'])

您好!我是由中国的深度求索(DeepSeek)公司开发的智能助手 DeepSeek-R1。如您有任何任何问题,我会尽我所能为您提供帮助。

1.4. 总结

现在我们在基于腾讯云私有化部署了自己的云端 AI 大模型,再也不用怕服务拥挤无法体验了,接下来可以将端口暴露出去再配合内网穿透工具等显示服务转发就能做成对外服务网站.

注意事项

腾讯云 Cloud Studio 每月提供 10000 分钟的免费时长,请再使用完免费的 GPU 资源后,记得关闭机器以避免不必要的资源浪费.

1.5. 推荐

- 免费制作红包封面还得是 AI 生成,附赠 AI 智能体提示词

- python 源码-好宝贝母婴每日签到赚积分

- 良心活动,无需实名,直接照抄答案就行,懂点 python 就能每天白嫖现金红包

- 懒人速成一分钟教你私人定制专属红包封面

- C 盘爆满飘红不用怕,教你三招搞定它,轻松释放几十 G 的磁盘空间!

- Mac 版本 Burpsuite 下载安装超详细教程,专业版中文激活教程(附下载)

- Burpsuite 下载安装超详细教程,社区版永久有效,专业版汉化激活到 2099 年,不看会后悔系列,亲测好用!

- 终极防窥秘籍!禁用右键+F12,竟还拦不住好奇宝宝?揭秘防窥新境界!

- 【硬核防白嫖秘籍】一键取关?直接拉黑,让你的公众号再无回头白嫖党!

- 谁家爬虫这么明目张胆?连 UserAgent 都不要了!

1.6. 关注

欢迎扫码关注,私信回复『加群』一起交流技术

作者: 雪之梦技术驿站

来源: 雪之梦技术驿站

本文原创发布于「雪之梦技术驿站」,转载请注明出处,谢谢合作!